La Inteligencia Artificial se está desarrollando de forma tan acelerada, que parece haber invadido ya todos los rincones de nuestra sociedad.

Sentimos que no somos capaces de identificar en qué aspectos de nuestra vida tiene o va a tener influencia, porque cada día que pasa recibimos noticias al respecto de todo tipo, un verdadero aluvión de información, y pensamos que quizás sirva para todo.

Y algo hay de eso, por ello en este blog vamos a intentar traer noticias de los últimos avances de la Inteligencia Artificial (IA) y algún comentario sobre su impacto, preferentemente sobre su impacto en la industria, que es lo que más nos interesa.

La IA puede ayudarnos, mucho, o puede causarnos problemas, y ello depende en gran medida de cómo integremos esta ola tecnológica en nuestro bagaje intelectual personal. Tenemos que aprender lo imprescindible de Inteligencia Artificial, no hay más remedio, igual que aprendimos a usar en su día las herramientas ofimáticas, la automática industrial o los conceptos básicos de ciberseguridad. Es el tiempo que nos toca.

Antes que nada, vamos a dedicar unas pocas líneas a ubicar en el tiempo este desarrollo actual, que para nada es espontáneo, sino que ha sido el resultado de muchos años de investigación y desarrollo.

Primeros pasos de la Inteligencia Artificial

Los sistemas actuales de Inteligencia Artificial utilizan elementos que en esencia son los mismos que en su origen, allá por el fin de la década de los 80. Sí, me refiero a las redes neuronales, esos programas que intentan imitar cómo funcionan las neuronas de nuestro cerebro. Se pusieron de moda en los círculos académicos en esa época (aunque se diseñaron unos años antes) y funcionaban de forma casi mágica, pues era el primer sistema informático del que no podías decir exactamente cómo había llegado a una conclusión. Actualmente, continúan de esta forma.

Fase de aprendizaje. Organizamos un conjunto de datos de entrada y los entrenamos con un conjunto de salida, previamente conocido, para que el sistema ajuste las relaciones entre los nodos (enlaces de neuronas) en un proceso iterativo que debe converger. Es el denominado “aprendizaje”.

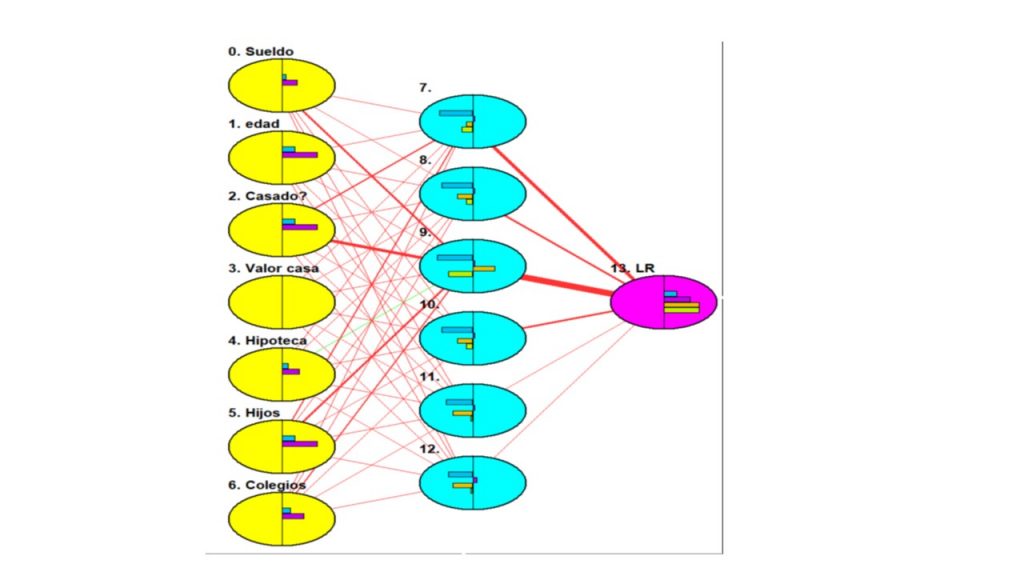

Ejemplo gráfico y real del funcionamiento de las redes neuronales

Vemos aquí un sencillo ejemplo de predicción del riesgo financiero en función de variables personales con una red de una sola capa. Pretendemos ilustrar el proceso de ajuste de los pesos en cada nodo.

Su principal problema era que se necesitaban muchos datos para “entrenarla”, una frase repetida era que no había red neuronal que funcionara bien con menos de 1.000 datos de entrada. Esa cantidad de datos parecía enorme en aquella época, en la que los ordenadores eran ridículamente lentos comparados con los actuales. Pero se consiguió que identificaran correctamente números escritos a mano y leer matrículas de coche. Un éxito increíble, pero que no prosperó demasiado porque al lado de cada sistema de Inteligencia Artificial se necesitaba un experto informático que se encargara de ponerlos a punto. Eso actuó de freno para limitar su expansión, y por otra parte la potencia de los equipos informáticos era insuficiente para las necesidades cada vez más exigentes de las redes neuronales, de forma que se necesitó que pasaran casi 20 años para que surgieran avances relevantes.

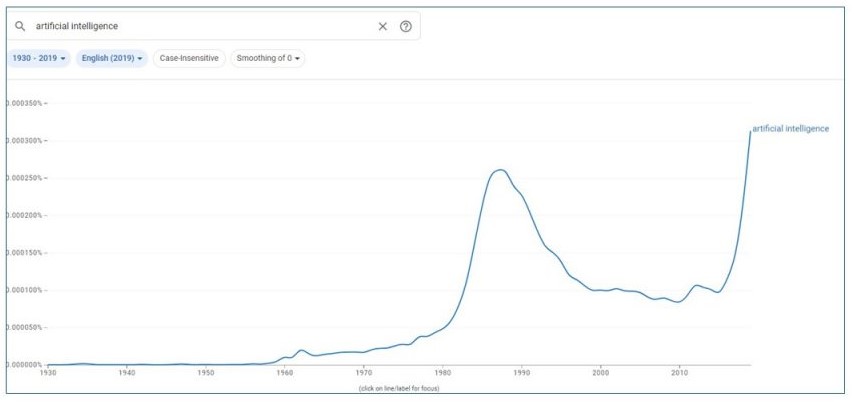

Esta situación se ve reflejada en el gráfico adjunto, en el que se muestran las referencias en la literatura al término “Inteligencia Artificial” en inglés, según Google. Puede observarse el pico centrado en 1990 y el valle subsiguiente, hasta que alrededor de 2015 se produce el inicio de la explosión actual.

*Tuve la suerte de trabajar en los años 90 y durante unos cuantos años en IA, fue una época esforzada por el limitado eco que tenía en la sociedad y puedo asegurar que el cambio que se ha producido recientemente es extraordinario.

El punto de inflexión de la Inteligencia Artificial

La publicación por parte de Google en 2017 del artículo “Todo lo que necesitas es atención” https://arxiv.org/pdf/1706.03762.pdf, (parafraseando el título de la canción de los Beatles), supuso el pistoletazo de salida para el desarrollo actual. En ese artículo, los ingenieros de Google presentaban una arquitectura especial para el análisis del lenguaje humano, llamada “Transformers”. Una arquitectura que suponía un cambio con respecto a lo mejor que había hasta ese momento en ese campo, la predicción pseudo-estadística de la próxima palabra en una frase. Este último sistema lo hemos conocido y sufrido en los correctores instalados en los teléfonos móviles.

La nueva arquitectura Transformers intenta, con artificios matemáticos, detectar y resaltar la palabra mas importante en una oración, de forma que la búsqueda del resto de palabras, ya sean anteriores o posteriores, se vea fuertemente matizada por la influencia de la palabra principal. Prefiero no entrar en detalles, pero están descritos en el artículo citado.

Este simple truco supuso un cambio fundamental, pues el tamaño de los conjuntos de datos de entrenamiento, a un siendo gigantescos, eran asumibles por los ordenadores existentes, y sobre todo por las tarjetas gráficas (GPU). Estos “accesorios” han sido la salvación de la Inteligencia Artificial (y el enriquecimiento de sus fabricantes, con NVIDIA como el principal beneficiario).

Situación actual de la IA

El escenario actual está en plena ebullición. La empresa de Google, Deepmind, que tuvo su éxito venciendo al juego del Go, no ha conseguido desbancar, con su nuevo producto Gemini, a su principal rival, OpenAI, que ahora está en la órbita de Microsoft.

OpenAI lanzó ChatGPT-v3 (la T viene de Transformer= Chat Generative Pre-trained Transformer) en 2021, y la versión 4 en marzo de 2023. En apenas dos meses ha roto todos los récords consiguiendo mas de 100 millones de usuarios. A finales de 2023 tenía 180 millones de usuarios activos al mes.

El entrenamiento de estos sistemas es algo fabuloso, si ChatGPT2 necesitó en 2019 40 Gb de datos, GPT4 está entrenado a su vez con 570 Gb de datos, tomados todos ellos de Internet y actualizado hasta septiembre de 2021. El resultado para GPT4 son 220 mil millones de parámetros.

Todos estos números marean, pero nos dan una idea de que estos sistemas funcionan a base de una enorme cantidad de datos y de capacidad proceso (y coste energético asociado). Hay muchas iniciativas para reducir estos valores, pero de momento el principal vencedor en la carrera es CHAT-GPT4 que al día de hoy está en el primer lugar de la mayoría de los rankings de IA. Y tiene previsto lanzar GPT-5 en este año 2024. Ya veremos.

Si observamos el entorno actual de IA, tenemos muchos sistemas, que siguen una multitud de arquitecturas y variantes, pero se detecta una clara distinción entre los que son de propósito general (Chat-GPT4, Mistral, Gemini, Claude-3 etc..) y los que se han especializado en algún nicho de aplicación, por ejemplo, la generación de imágenes (Midjourney, Leonardo-AI, DALL-E3 etc…), la voz y el video, etc…

Aplicación de la inteligencia artificial en ciberseguridad industrial

Con estos antecedentes y todo este panorama ya podemos empezar a analizar la importancia de la IA y su impacto en nuestras actividades industriales.

Para empezar, existe toda una serie de aplicaciones que no tienen relación con el control de procesos y que son similares a las que pueden encontrarse en otras áreas de la informática corporativa, entre las que podemos citar, logística de producción y aprovisionamiento, planificación, optimización, análisis de mercado, marketing de clientes, estudio de tendencias y series temporales etc…

Aquí vemos cómo se utilizan versiones preliminares de la actual IA, con las arquitecturas de Machine learning (ML), Deep Learning e incluso del ya “antiguo” Big Data. También debemos considerar en este apartado las aplicaciones en el ámbito de la ciberseguridad, con el análisis básico del comportamiento del tráfico de red, detección de anomalías, ayuda para la gestión de incidentes, correlación e interpretación de eventos en logs, análisis de malware etc…

Y, por otro lado, está la aplicación de la IA en el control de procesos industriales, en ocasiones en tiempo real, identificando al vuelo errores de instrumentación, tendencias y derivas indeseadas en variables de control, optimización de lazos de control vinculados, robótica avanzada etc…

Como vemos, el campo de aplicación es inmenso, pero con ser muy importante estar al tanto de todo lo mencionado, que analizaremos en detalle, no debemos olvidar que, como toda tecnología, tiene su versión oscura, la de aquellos que la utilizan con propósitos maliciosos. Un aspecto extremadamente peligroso que puede suponer un cambio de modelo (paradigma) en la creación y explotación de malware.

Conclusión

En este primer capítulo del blog hemos introducido la historia y algunos conceptos de AI, pero lo interesante vendrá en próximos capítulos. Nuestro plan es hacer un mix entre la presentación de novedades en IA y la revisión de las aplicaciones y principales amenazas que están apareciendo, de forma que podamos sacar el máximo partido a esta lectura.